Vous êtes ici

Réseaux sociaux : les rouages de la manipulation de l’opinion

Le Politoscope que vous pilotez offre un autre regard sur la campagne présidentielle. Quel est l’objectif de cet outil lancé 2016 à l’Institut des systèmes complexes et qui avait déjà fait ses preuves lors de la campagne précédente ?

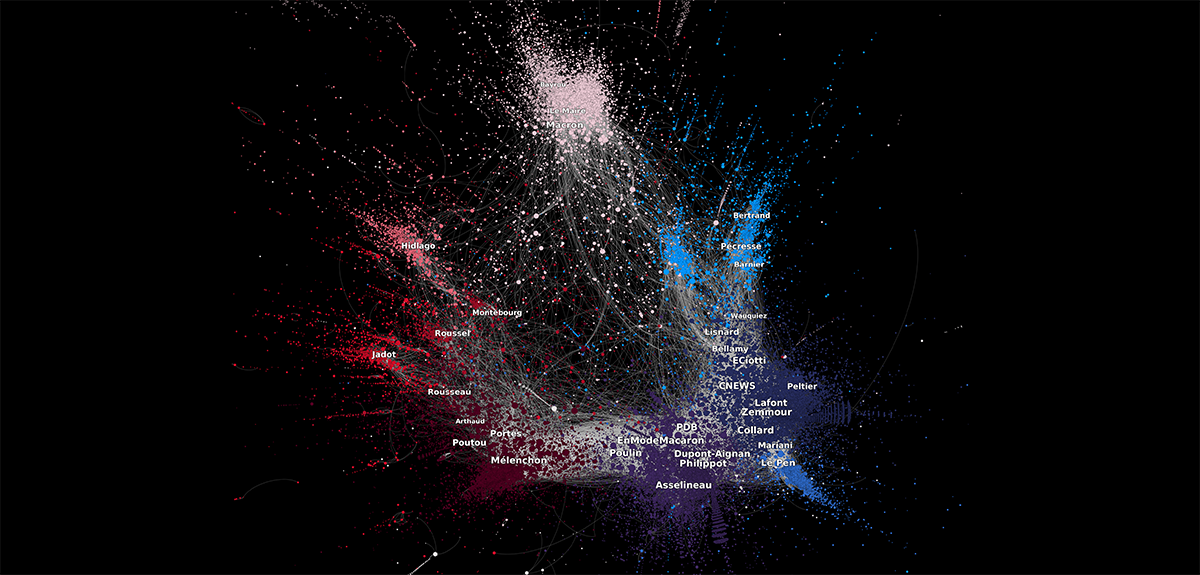

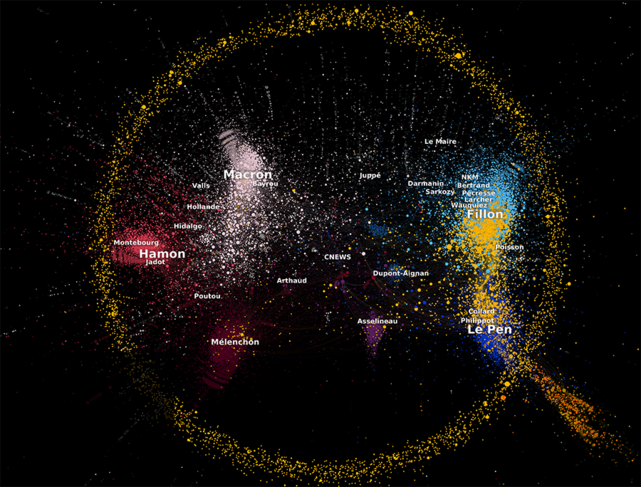

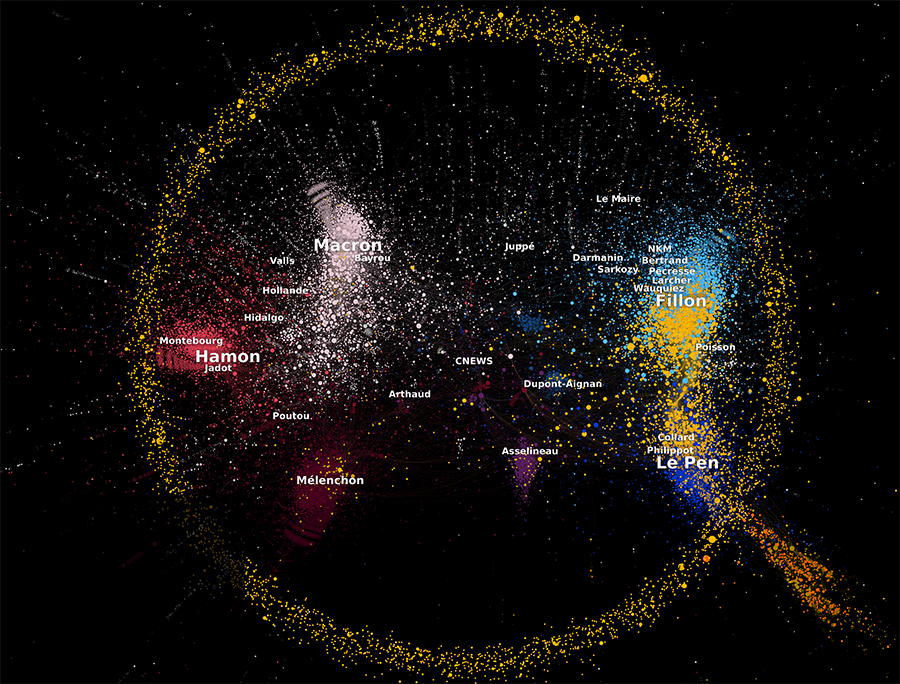

David Chavalarias1. Le but du Politoscope est de permettre au grand public de plonger dans les masses de données générées sur les réseaux sociaux à l’approche des présidentielles grâce à des outils et méthodes d’analyses produits par la recherche. L’ambition est d’une part d’aider à mieux contextualiser sur le temps long les prises de parole des hommes politiques ; d’autre part, de permettre d’identifier sur les temps courts des actions collectives visant à influencer le débat public. Le Politoscope se concentre sur les réseaux sociaux mais principalement sur Twitter, un média très utilisé par les personnalités politiques et leurs bases militantes. Il suit environ 3 000 personnalités politiques élues et responsables de partis, ainsi que des mots-clés spécifiques comme #présidentielle2022 ou #régionales, et aspire chaque jour entre 500 000 et 2 millions de tweets. Il propose une lecture de l’évolution des groupes sociaux, des alliances entre partis politiques et de ce qu’ils diffusent.

Quels sont les différents types de manipulations d’opinion que vous mettez en évidence ?

D. C. En 2017, nous avons observé trois types de manipulation : la plus classique consiste à diffuser des fausses informations pour influencer le vote, le plus souvent en dénigrant une personnalité politique. De l’autre côté du spectre, on trouve des opérations qui consistent à révéler, juste avant un scrutin, des données personnelles ou internes à certains partis politiques sans donner le temps de vérifier les accusations, dans l’espoir de semer le doute pour qu’une tranche de l’opinion change son vote. Je pense notamment aux Macron Leaks, publiés tout juste avant le deuxième tour de 2017.

Le troisième type de manipulation consiste à démultiplier les messages en ligne avec des informations orientées. Toutes ces manipulations se font généralement sans révéler l’identité de l’auteur, voire en laissant croire à une autre identité. Par exemple, en 2017, de très nombreux messages hostiles à Benoît Hamon, Jean-Luc Mélenchon ou Emmanuel Macron reprenant les codes des communautés politiques de François Fillon et Jean-Luc Mélenchon, étaient écrits par des personnes étrangères, a priori des membres de l’extrême droite américaine que nous avons pu suivre sur le forum 4chan. À l’occasion d’élections importantes, ces communautés s’organisent en ligne pour tenter de faire avancer l’agenda de cette nouvelle extrême droite internationalisée.

Comment expliquer ces manipulations à travers le numérique ?

D. C. Démultiplier une présence en ligne, à travers des comptes gérés par des robots ou des humains, pousse à faire croire qu’un nombre plus important de personnes adhèrent ou rejettent une idée que ce n’est le cas dans la réalité.

Nous avons tous une tendance naturelle, en situation d’indécision, à regarder ce que pensent les autres pour se faire une idée. En modifiant la perception de l’importance de l’adhésion de votre entourage à une cause, il est ainsi possible d’augmenter la probabilité que vous adhériez vous-même à cette idée. Par ailleurs, cette amplification artificielle de l’activité en ligne permet de manipuler les algorithmes de recommandation des plateformes numériques qui vont diffuser vos contenus bien au-delà du cercle des utilisateurs déjà acquis à vos idées.

Infléchir l’opinion de 10 % des utilisateurs peut être suffisant pour arriver à ses fins, quand on sait que 10 % des utilisateurs français de Twitter représentent 900 000 personnes. C’est plus que l’écart de voix entre Marine Le Pen et Jean-Luc Mélenchon ou François Fillon pour passer le premier tour en 2017.

Comment le numérique fracture-t-il le tissu social ?

D. C. L’usage des réseaux sociaux n’a même pas vingt ans. On a donc peu de recul sur l’impact qu’ils ont sur l’organisation de la vie sociale à l’échelle d’un pays. L’ensemble des informations dans le monde numérique est contrôlé par les plateformes comme Facebook ou Twitter. Or, ces environnements numériques apprennent de vos actions et de celles des autres pour savoir quoi vous montrer. On sait qu’il existe un biais qui nous pousse vers des informations anxiogènes. Par exemple, au moment de la découverte d’un vaccin, si un titre vous dit qu’il est efficace à 90 % et un autre annonce qu’il rend stérile, la plupart des gens vont d’abord regarder le second type de message.

Peuvent alors se former des chambres d’écho, à savoir des ensembles de personnes qui interagissent de manière privilégiée et finissent par penser la même chose quand bien même ce serait des faits alternatifs. Frances Haugen, lanceuse d’alerte de Facebook a ainsi révélé, fin 2021, que Facebook avait orienté sur moins de 4 % de ses utilisateurs plus de 80 % de la désinformation liée au Covid. Des catégories de population se retrouvent ainsi enfermées avec une seule vision du monde qui peut être totalement erronée, ce qui peut conduire à une balkanisation de l’opinion publique caractérisée par une hostilité excessive entre groupes. Ce mécanisme a atteint son paroxysme aux États-Unis, avec une bipolarisation accrue qui a abouti à l’invasion du Capitole le 6 janvier 2021.

Selon vos récentes observations, y a-t-il une aggravation de ces dérives en France ?

D. C. On a observé une radicalisation en cinq ans. En 2017, le paysage politique allait de l’extrême gauche à l’extrême droite et l’information circulait par les partis modérés tels que le PS, LREM et LR. Maintenant, deux nouvelles communautés numériques d’extrême droite très influentes ont émergé autour d’Éric Zemmour et de Florian Philippot. La communauté de ce dernier a été particulièrement active lors de la pandémie, qui a fourni des opportunités assez importantes pour créer de l’hostilité envers le gouvernement et les partis traditionnels. Nous avons aussi observé qu’une grande partie des militants en ligne de François Fillon et Marine Le Pen en 2017 militent désormais dans les communautés numériques de Florian Philippot ou d’Éric Zemmour. Dans cette dernière, nous avons constaté des actions coordonnées et récurrentes sur les réseaux sociaux qui visent à créer de la polarisation.

Juillet 2021, les Kremlin Papers révélaient la stratégie déployée par la Russie contre les États qui l’avaient sanctionnée après la crise ukrainienne de 2014. La nouvelle guerre en Ukraine va-t-elle intensifier les interventions russes sur les médias sociaux occidentaux ?

D. C. Depuis 2013, la Russie s’est fait une spécialité d’intervenir à l’extérieur dans le domaine numérique. Elle s’inspire de la pensée de Sun Tzu, un stratège chinois du VIe siècle av. J.-C., qui préconisait de ne pas faire de distinction entre-temps de paix et de guerre et de ne cesser d’affaiblir l’ennemi sur son propre terrain.

La Russie s’est ainsi consacrée à intervenir aux États Unis et en Europe pour amplifier les divisions entre les citoyens et leur gouvernement en diffusant de fausses informations, en faisant de la propagande pro-Kremlin, et en rendant des personnalités politiques ou des hommes d’affaires dépendants à sa cause en les finançant ou en les impliquant dans des affaires en Russie. C’est notamment le cas de François Fillon, qui est entré dans le directoire de plusieurs compagnies.

L’agence de recherche internet (IRA) compte plusieurs centaines de salariés à Saint-Pétersbourg, qui passent leur journée à faire de la désinformation sur les réseaux sociaux. Exemple typique : lors des premiers jours de combat en Ukraine, ils ont essayé de faire croire que le gouvernement ukrainien avait pris la fuite. Si cette fausse rumeur avait vraiment pris, les troupes ukrainiennes ne se seraient pas battues avec autant de vigueur.

Les plateformes sont-elles aujourd’hui mieux armées pour lutter contre cette désinformation ?

D. C. Les problèmes persistent car seules leurs équipes ont accès à leurs données comme à leur algorithme. Or, contrôler les informations sur 2,8 milliards d’utilisateurs Facebook demande des moyens colossaux. À moins qu’il existe un risque juridique et d’image pour la société, Facebook n’a aucun un intérêt à investir massivement là-dedans. Deuxième point : leur modèle économique se base sur la publicité et les recommandations. Frances Haugens a révélé que Facebook a changé ses critères en 2018 : avant cette date, le critère générique de l’algorithme était le temps passé sur les contenus. Désormais, c’est l’engagement, à savoir le nombre de clics, de commentaires et de publications, qui génère plus de profits malgré le fait que les biais cognitifs rendent ces environnements plus toxiques. Tant que le principal critère qui régira la circulation d’information sur ces plateformes sera économique, celles-ci ne pourront pas lutter efficacement contre la désinformation.

Selon vous, le modèle économique actuel de la Big Tech, fondé sur la marchandisation de l’influence sociale, est incompatible avec la pérennité de nos démocraties.

D. C. Tout à fait, et ce notamment en raison de l’un des premiers théorèmes en sciences sociales, le théorème de Heinz von Foerster-Dupuy2. Ce théorème de la théorie des systèmes, interprété dans le cadre des sociétés humaines, nous dit que lorsqu’on augmente la quantité d’information sociale, les dynamiques collectives deviennent à la fois plus prononcées, plus massives et plus imprévisibles.

De grands ensembles de personnes vont par exemple chercher à acheter la même chose ou suivre un leader populiste. Une autre partie du théorème explique que, si vous possédez l’ensemble des données sur les comportements d’une population, vous êtes plus à même de prédire la direction de ces mouvements collectifs lorsque le niveau d’information sociale augmente. C’est ce qui permet par exemple à Amazon de prédire, à l’avance, le succès d’un livre et d’ajuster sa logistique en fonction.

La prédiction du comportement des consommateurs se révélant lucrative pour les plateformes, celles-ci ont tout intérêt à rendre leurs plateformes plus « sociales », et par conséquent les collectifs humains plus instables. Enfin, l’augmentation de l’information sociale dans une société renforce les « dépendances au chemin », c’est-à-dire le fait que les premiers moments d’une dynamique collective sont déterminants pour sa suite. Ceci donne un pouvoir énorme à ceux qui sont capables d’agir sur un système social dès le début de ses dynamiques, notamment les manipulateurs d’opinion.

Ces mécanismes constituent-ils un risque pour nos démocraties ?

D. C. Si les grandes plateformes numériques continuent de faire du critère économique l’étalon pour régir la circulation d’information au sein de nos sociétés, nos démocraties risquent d’être balayées par des mouvements populistes. Ceux-ci profitent en effet de la « manipulabilité » de notre environnement informationnel sur les réseaux sociaux et de la faiblesse des institutions, comme Jair Bolsonaro au Brésil ou Viktor Orbàn en Hongrie. Le risque est particulièrement élevé en France où les failles de notre mode de scrutin présidentiel – le même qu’au Brésil – font qu’une personnalité jouant sur la corde de la radicalité peut passer au second tour même si elle est rejetée par une majorité de la population. La balkanisation de l’opinion publique sous l’effet de campagnes électorales de plus en plus négatives fait que les personnes dont le candidat n’a pas été sélectionné au premier tour peuvent être fortement tentées de s’abstenir ou de voter pour un candidat populiste au second tour. Même rejeté par la majorité de la population, un candidat peut donc être élu en réunissant entre 20 et 30 % des suffrages dans un contexte de forte abstention.

Avez-vous des préconisations pour contrer ces phénomènes ?

D. C. Sans être exhaustif, je propose 18 mesures dans Toxic Data. On peut d’abord prendre des mesures individuelles, qui concernent l’hygiène de vie numérique. Concernant les mesures collectives, pour n’en mentionner que deux, il y a urgence à changer le mode de scrutin, en adoptant par exemple le jugement majoritaire, système de vote beaucoup moins manipulable et qui rend impossible l’élection d’une personne rejetée par une majorité. Il convient également de s’atteler à la régulation des plateformes numériques à l’heure où la modification d’une ligne de code sur une plateforme comme Facebook a un impact immédiat sur la vie quotidienne de 2,8 milliards d’individus. Je propose de réfléchir à une loi sur l’atteinte à la vie démocratique : si une plateforme déployée à l’échelle d’un pays se révèle à même de porter atteinte à sa cohésion sociale, ses algorithmes devraient pouvoir être audités par une instance ad hoc et des adaptations devraient pouvoir être imposées. Il est tout à fait possible de légiférer pour permettre à la fois la participation d’entreprises privées à la circulation de l’information sociale et une meilleure robustesse du vote et des institutions face aux manipulations d’opinion. ♦

À lire

Toxic Data. Comment les réseaux manipulent nos opinions, David Chavalarias, Flammarion, mars 2022, 300 p., 19 euros (disponible au format e-book).

Pour en savoir plus sur le Politoscope : https://politoscope.org

À lire sur notre site :

Internet, l'autoroute de la désinformation ?

L’étonnante acceptabilité des deep-fake

- 1. Directeur de recherche au CNRS, directeur de l’Institut des systèmes complexes de Paris Île-de-France (ISC-PIF, unité CNRS).

- 2. De Heinz von Foerster, l’un des fondateurs de la seconde cybernétique et Jean-Pierre Dupuy, ancien professeur à l’École polytechnique qui enseigne actuellement à Stanford.

Mots-clés

Partager cet article

Auteur

Spécialisé dans les thématiques liées aux religions, à la spiritualité et à l’histoire, Matthieu Sricot collabore à différents médias, dont Le Monde des Religions, La Vie, Sciences Humaines ou encore l’Inrees.

Commentaires

Connectez-vous, rejoignez la communauté

du journal CNRS