Vous êtes ici

Quand le cloud se fait diffus

Dans le monde des systèmes distribués, où les ressources informatiques telles que la mémoire et la puissance de calcul sont réparties entre plusieurs machines différentes, le cloud a connu une démocratisation fulgurante ces quinze dernières années. Il n’est cependant pas le seul système de traitement et de stockage à distance des données. « Un cloud est typiquement constitué d’un grand centre de données, ou de plusieurs centres moyens, mais ce système arrive à ses limites car il est de plus en plus difficile de concentrer les ressources informatiques, explique Guillaume Pierre, professeur à l’université de Rennes et membre de l’Institut de recherche en informatique et systèmes aléatoires1 (Irisa). On s’est alors rendu compte que transmettre des données très loin pour qu’elles soient traitées en masse dans de grands centres n’était pas toujours la meilleure solution. »

Des données traitées et stockées à proximité

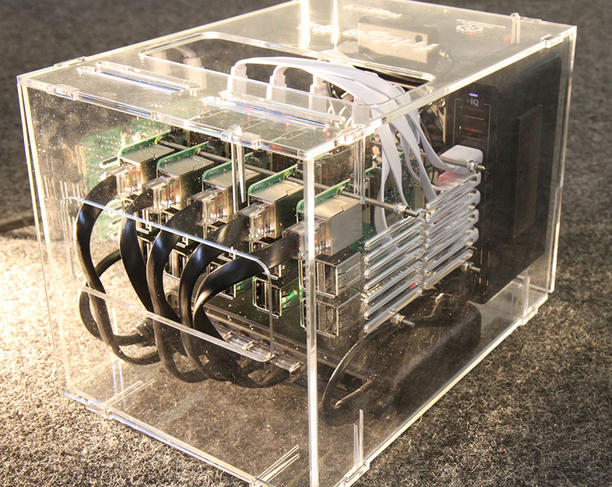

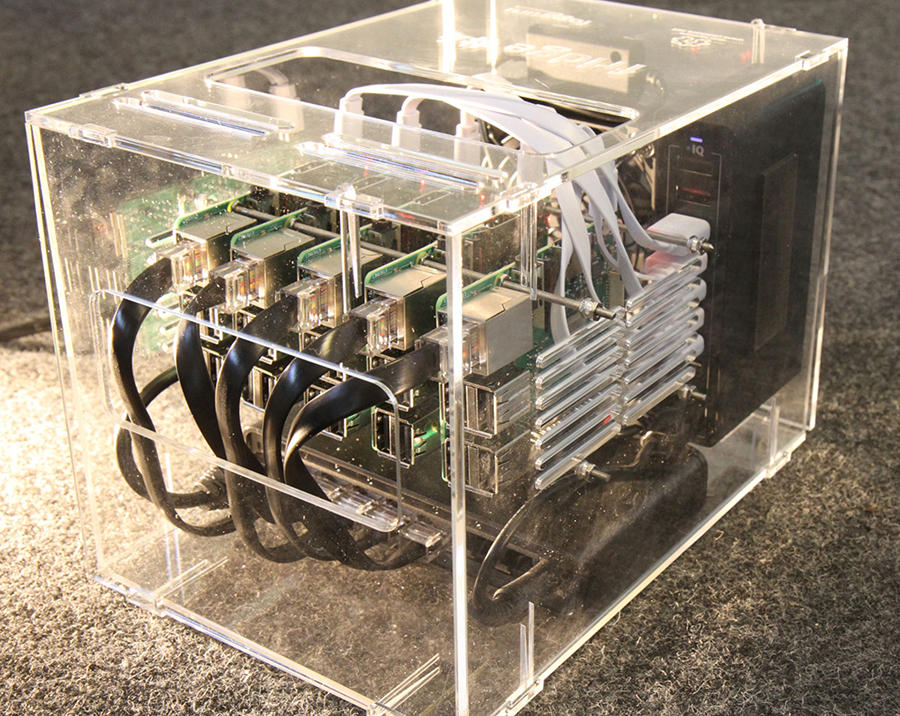

Le fog computing (informatique en brouillard, en français, ndlr) est une réponse à ces problématiques. Les données y sont traitées sur des nœuds du réseau plus proches de leur source et plus réduits. Dans le cas de capteurs et d’objets connectés, l’envoi d’informations sur un petit serveur local, qui ne les fera suivre sur des machines plus puissantes qu’en cas de besoin, peut ainsi suffire. Car dépendre d’importants centres de données peut mener à des écueils. À cause des différentes législations, on peut préférer que les données personnelles, médicales ou militaires ne soient pas stockées à l’étranger. L’éloignement peut également entraîner de la latence, ce qui ne pose pas de problème quand on souhaite juste consulter ses mails, mais qui nuit à des applications critiques ou interactives. Cela va du jeu vidéo à la chirurgie à distance.

« Le défi du fog computing est de conserver les bonnes propriétés du cloud, comme la souplesse et la puissance, tout en répartissant plus efficacement les ressources, affirme Guillaume Pierre. Cependant, de nombreux modèles et hypothèses pensés pour le cloud fonctionnent mal, voire pas du tout avec le fog computing. Il faut donc réinventer les architectures de ces systèmes. »

Par exemple, les machines sont physiquement très proches les unes des autres dans les centres de données, ce qui augmente la fiabilité des calculs et réduit la latence dans le traitement des informations. Leurs connexions par câbles sont en effet bien plus rapides que les réseaux à grande échelle qu’utilise le fog computing, comme la 5G, l’ADSL ou la fibre. La gestion de machines dispersées requiert également une optimisation particulière des flux et du réseau. Si les données sont traitées dans des nœuds moins éloignés qu’un gros centre de données situé à l’étranger, mais que les communications entre ces nœuds sont mal optimisées, les données peuvent au final parcourir de plus grandes distances.

Des expérimentations dans le cadre d'un projet européen

Ces axes de recherche et d’amélioration ont notamment été mis en pratique dans le cadre de FogGuru, coordonné par Guillaume Pierre. « Ce projet européen de formation doctorale a permis à huit doctorants d’exercer leurs talents sur le fog computing, explique le chercheur. La ville de Valence, en Espagne, nous a en quelque sorte donné les clés de la ville pour expérimenter ces technologies. »

Deux cas d’usage ont ainsi été étudiés. Le premier concernait la distribution de l’eau potable, une ressource précieuse dans cette zone semi-aride. Deux-cent-mille compteurs intelligents étaient déjà installés chez les habitants afin de détecter les fuites, mais le système ne donnait pas de résultats satisfaisants. « Il fallait trois ou quatre jours pour repérer un problème, détaille Guillaume Pierre. Avec le fog computing, nous récupérons et traitons des données jusqu’à une fois par heure, si bien que nous pouvions alerter les techniciens dans la demi-journée. Nous avons développé un prototype de compteur, mais il n’a pas pu être déployé à grande échelle à cause de la pandémie (de Covid-19, ndlr). »

Le second cas d’usage, qui a lui été finalisé, concernait la marina de Valence. Il s’agissait d’implanter des capteurs pour mesurer la force du vent et des vagues, des relevés météo ainsi que les entrées et sorties du site, puis d’utiliser ces données pour faciliter la gestion des lieux. Un hackathon a été organisé par FogGuru, remporté par une équipe qui a conçu un modèle mathématique de l’ensablement de la marina. « Plutôt que de draguer tout le secteur, ce qui coûte un à deux millions d’euros par an, cette solution devrait permettre de réduire ces travaux à des zones prioritaires ne couvrant que 10 % de la marina, se réjouit Guillaume Pierre. Ce traitement fonctionne sans avoir à envoyer les données, qui n’ont d’utilité que pour le port de Valence, vers un serveur lointain. »

Des pistes pour diminuer la consommation énergétique

Le fog computing suscite également un intérêt en tant qu’alternative à l’énorme consommation énergétique des centres de données. « L’économie d’énergie n’est en général pas la raison première de préférer le fog computing, car ce système est pour l’instant moins bien optimisé que le cloud, tempère Guillaume Pierre. Mais à notre époque, on ne peut plus se permettre de ne pas prendre en compte cette question. Nous étudions donc l’efficacité énergétique des plateformes de fog computing, mais nous ne sommes pas au bout du sujet. »

Cette thématique rejoint celles chères à Jean-Marc Pierson, professeur à l’université de Toulouse et directeur de l’Institut de recherche en informatique de Toulouse2 (Irit), spécialiste de l’efficacité énergétique des systèmes distribués. Il est également membre du Groupement de service pour une informatique éco-responsable du CNRS (GDS EcoInfo). « La difficulté est que le fog computing ne remplace pas le cloud, mais s’y ajoute, avance Jean-Marc Pierson. La consommation globale augmente donc. Le fog computing utilise cependant des installations plus petites, elles demandent moins d’infrastructures, ont moins besoin d’être refroidies et elles peuvent être plus facilement alimentées en énergies renouvelables 3. Il faudrait réaliser des études sur le cycle de vie complet des différents centres de calcul afin de vraiment savoir quel système est le plus sobre. »

Parmi les autres axes de recherche, concernant le fog computing et les systèmes distribués en général, le scheduling, c’est-à-dire l’ordonnancement optimisé des tâches informatiques, est très prisé. La réduction de la réplication des données est également étudiée, par exemple pour des fichiers lourds et populaires comme les vidéos et la musique. « Nous regardons aussi l’acceptation par les utilisateurs d’un service dégradé, poursuit Jean-Marc Pierson. Un service plus lent et des images de moindre qualité permettent d’importantes économies d’énergie. C’est presque une question philosophique : est-ce vraiment utile de solliciter immédiatement ces services chaque fois qu’on les désire ? »

Avec son accent sur des systèmes de calculs moins puissants, et donc moins énergivores, le fog computing pourrait répondre à ces approches de la sobriété énergétique. Il faudra cependant continuer à adapter et optimiser les systèmes existants pour que cette architecture se déploie pleinement.♦

À lire sur notre site

Comment rendre les applications moins énergivores ?

Les défis de l'Internet des objets

- 1. Unité CNRS/Université de Rennes.

- 2. Unité CNRS/Institut national polytechnique de Toulouse/Université Toulouse - Paul Sabatier.

- 3. https://www.irit.fr/datazero/index.php/en/

Voir aussi

Auteur

Diplômé de l’École supérieure de journalisme de Lille, Martin Koppe a notamment travaillé pour les Dossiers d’archéologie, Science et Vie Junior et La Recherche, ainsi que pour le site Maxisciences.com. Il est également diplômé en histoire de l’art, en archéométrie et en épistémologie.