Vous êtes ici

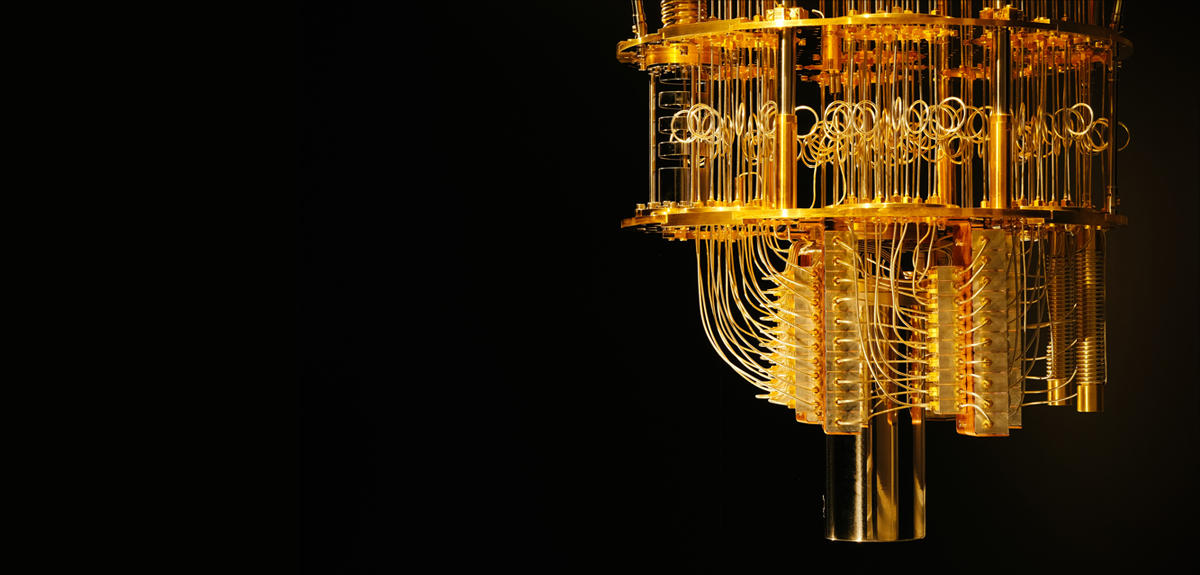

Ordinateur : les promesses de l'aube quantique

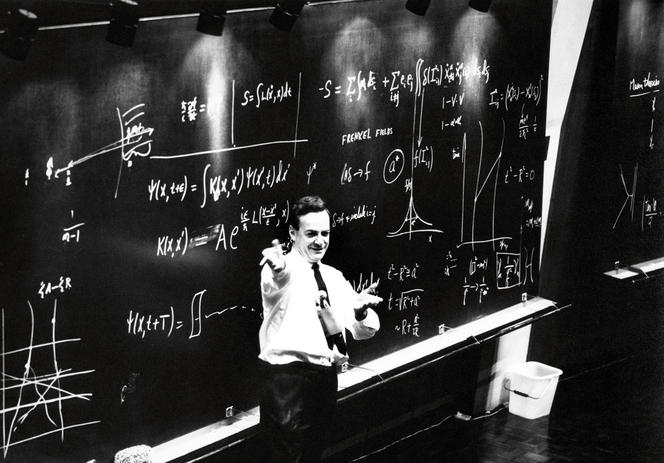

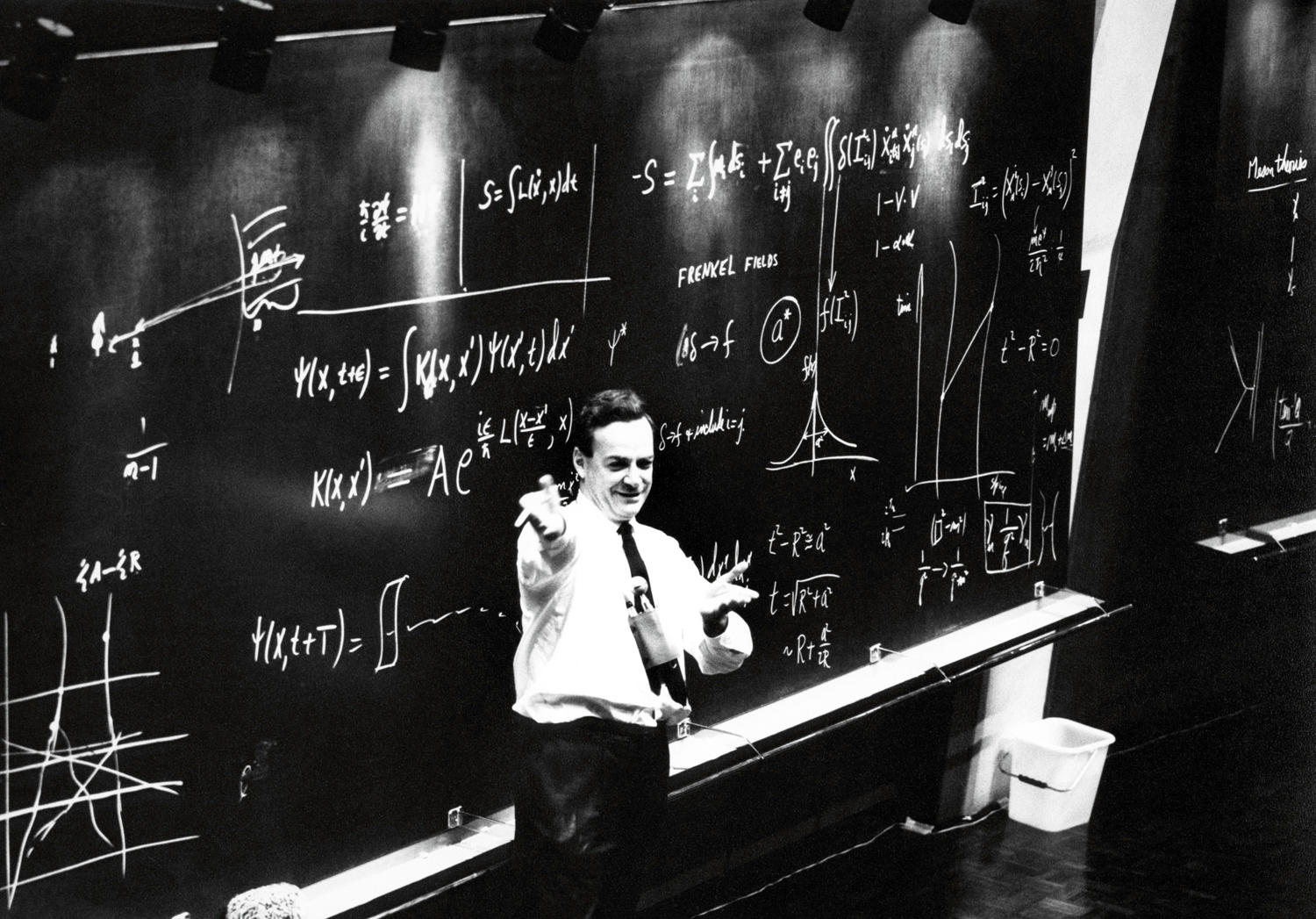

Les supercalculateurs les plus puissants de la planète pourraient bientôt être renvoyés à la préhistoire de l’informatique. D’ici à quelques années, pour les plus optimistes, des machines d’un nouveau genre, offrant des capacités de calcul phénoménales, feront leur apparition : les ordinateurs quantiques. Imaginé au début des années 1980 par le Prix Nobel de physique Richard Feynman, le concept d’un tel ordinateur devient aujourd’hui de plus en plus une réalité. « Nous vivons actuellement une époque charnière où les industriels, comme Google ou IBM, s'emparent du sujet qui était resté jusqu’ici l’apanage des laboratoires de recherche et cela promet de nous faire passer des caps technologiques majeurs », se réjouit Tristan Meunier, de l’Institut Néel1. Même son de cloche pour Eleni Diamanti, du Laboratoire d’informatique de Paris 62. « Dans les prochaines années, on disposera d’ordinateurs quantiques suffisamment performants pour battre nos ordinateurs traditionnels sur certains problèmes. »

La puissance de la superposition et de l’intrication

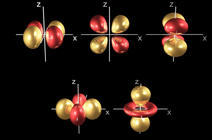

Comme son nom l’indique, un ordinateur quantique tire parti des lois de la mécanique quantique, une théorie qui décrit les phénomènes physiques à l’échelle atomique. Ces étonnantes lois autorisent une particule, un atome ou une molécule à se trouver dans différents états en même temps – on parle d’états superposés. Ainsi, alors que dans un ordinateur ordinaire, les informations sont codées sous la forme de bits qui ne peuvent prendre que deux valeurs, 0 ou 1, selon le passage au non de courant électrique à travers un transistor, les bits quantiques (ou qubits) peuvent simultanément prendre les valeurs 0 et 1. Qui plus est, lorsque deux qubits interagissent, leurs états physiques « s’enchevêtrent », si bien que les deux systèmes ne peuvent plus être décrits de façon indépendante – on parle d’états intriqués.

Grâce à ces deux phénomènes, la superposition et l’intrication, un ordinateur quantique peut en théorie avoir accès à la totalité des résultats possibles d’un calcul en une seule étape, là où un ordinateur classique doit traiter l’information de façon séquentielle, un résultat après l’autre. C’est ce parallélisme massif qui est au cœur de la puissance de l’ordinateur quantique.

La vitesse de calcul des algorithmes quantiques

Dès les années 1990, les chercheurs ont proposé des algorithmes pour de tels ordinateurs. Et démontré mathématiquement que mis en œuvre sur ces machines, ils réaliseraient effectivement certains calculs à une vitesse dépassant tout ce qu’on pourrait imaginer avec un ordinateur classique. Ainsi, en 1994, le mathématicien américain Peter Shor, du MIT, présente un algorithme avec lequel il serait possible de factoriser n’importe quel nombre, c'est-à-dire le décomposer en un produit de nombres premiers, en un temps record.

De quoi casser la plupart des systèmes de cryptographie actuels, du chiffrement de nos transactions bancaires aux codages permettant d’échanger des secrets d’État, qui reposent précisément sur l’explosion en temps de calcul de la factorisation pour des nombres de plus en plus grands. Un problème de ce genre qui prendrait plusieurs milliards d’années à un ordinateur classique serait ainsi résolu en quelques minutes par un ordinateur quantique !

De même, en 1997, Lov Grover, des laboratoires Bell, démontre avec son algorithme qu’un ordinateur quantique pourrait considérablement augmenter l’efficacité des algorithmes classiques utilisés pour la recherche d’informations sur une base de données.

Par exemple, la recherche d’un élément parmi dix mille données nécessiterait seulement une centaine d’étapes, contre dix mille pour un ordinateur traditionnel. Le gain de temps pour le traitement des données massives serait considérable. On comprend alors l’intérêt de sociétés comme Google pour cette nouvelle technologie.

L’accumulation de qubits

Restait ensuite à mettre au point les briques de base de ces ordinateurs quantiques, les fameux qubits, capables d’être dans deux états à la fois. Rapidement, les physiciens s'y sont attelés, partout dans le monde. De nombreux candidats ont ainsi été expérimentés : des atomes, des ions, des molécules, des électrons, des photons ou encore des circuits supraconducteurs. Avec, déjà, de beaux succès dans la manipulation de ces qubits. Ainsi, en 2003, Rainer Blatt, de l’université d’Innsbruck, en Autriche, a réalisé la première porte logique à deux qubits en utilisant des ions calcium, un dispositif clé pour pouvoir effectuer des opérations en couplant les qubits entre eux.

Quant à la plus belle prouesse calculatoire, elle a été accomplie en 2012 par une équipe de l’université de Bristol, en Angleterre, qui est parvenue à factoriser 21, soit à montrer que ce nombre se décompose en 3 fois 7, grâce à un dispositif photonique. Certes la performance est modeste, mais elle représente une démonstration de principe de l’algorithme de Shor, dont la puissance devrait se révéler pour des nombres beaucoup plus grands.

Car, on l’aura compris, l’avantage du calcul quantique sur son équivalent classique est d’autant plus grand que la quantité d’informations à traiter est élevée. En d’autres termes, « pour être performant et présenter un intérêt, un ordinateur quantique devra comporter un grand nombre de qubits. Pour les problèmes de factorisation par exemple, il faudra en coupler un millier, au bas mot », précise Simon Perdrix, du Laboratoire lorrain de recherche en informatique et ses applications3.

Le frein de la décohérence

Et c’est bien là le problème. « Pour qu’un ordinateur quantique fonctionne, il faut que ses qubits conservent leurs propriétés quantiques le temps du calcul. Or, du fait des interactions avec l’environnement (champ magnétique, lumière, agitation thermique...), tout pousse un système quantique à perdre ses propriétés. Et cela est d’autant plus vrai que le système contient plus de qubits », explique Sébastien Tanzilli, de l’Institut de physique de Nice4 et qui représente la France au sein du Quantum Community Network, le comité chargé de piloter l’initiative européenne Quantum Technologies Flagship. Ce phénomène baptisé décohérence constitue l’obstacle principal dans la construction de ces ordinateurs.

Mais loin d’être découragés, les physiciens, dès le début, ont tenté de mieux comprendre le processus et ils ont tout fait pour le contrôler. Résultat : depuis la mise au point des premiers qubits, voici environ vingt-cinq ans, leur temps de cohérence n’a cessé d’être allongé et on est parvenu à intriquer un nombre toujours plus grand de qubits. « Les progrès en matière de conception des qubits et de leur manipulation ont fait qu’on a pu repousser, lentement mais sûrement, la limite du nombre de qubits, et personne ne peut dire aujourd’hui où se situe cette limite », constate Tristan Meunier.

Actuellement, le record du nombre de qubits intriqués est de 20. Il est vrai que Google a annoncé en 2018 avoir réalisé un processeur quantique constitué de 72 qubits, mais sans démontrer combien d’entre eux ont pu effectivement être intriqués.

Des implémentations prometteuses

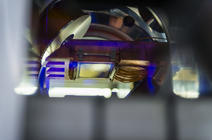

Dans cette course au nombre de qubits et à la réalisation de l’ordinateur quantique, deux systèmes sont aujourd’hui au coude à coude et offrent les perspectives les plus intéressantes. Le premier : les ions piégés. Développés au début des années 1990, il s’agit d’atomes – de calcium notamment – auxquels on a retiré un ou plusieurs électrons et qu’on piège sous vide à l’aide de lasers. Ce sont eux qui détiennent le record du temps de cohérence, qui peut atteindre plusieurs minutes dans certains dispositifs. La contrepartie, c’est qu'ils sont lents à manipuler, ce qui aurait pour conséquence de ralentir les calculs. Autre inconvénient : « Les techniques de piégeage sont relativement compliquées à mettre en place si bien qu’on a du mal à imaginer comment on pourra monter en taille et atteindre le millier de qubits », note Sébastien Tanzilli. Certains imaginent déjà des solutions pour y parvenir, mais le défi reste de taille.

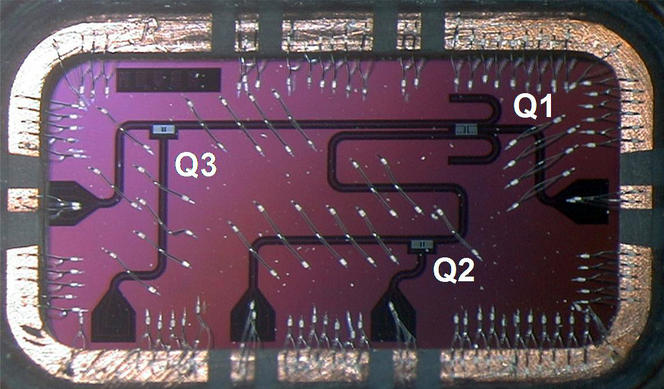

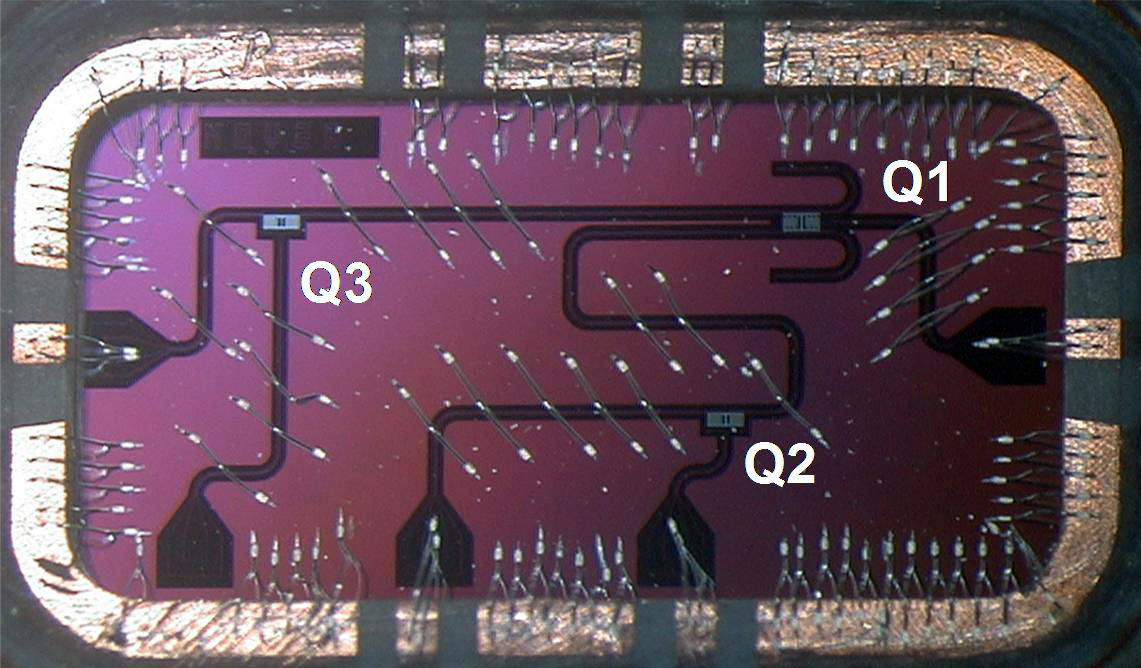

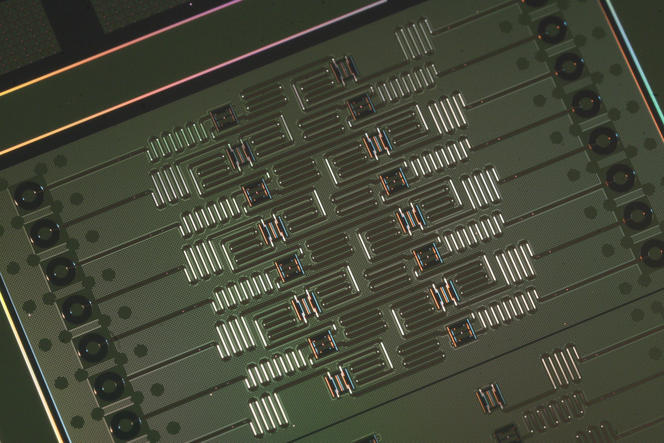

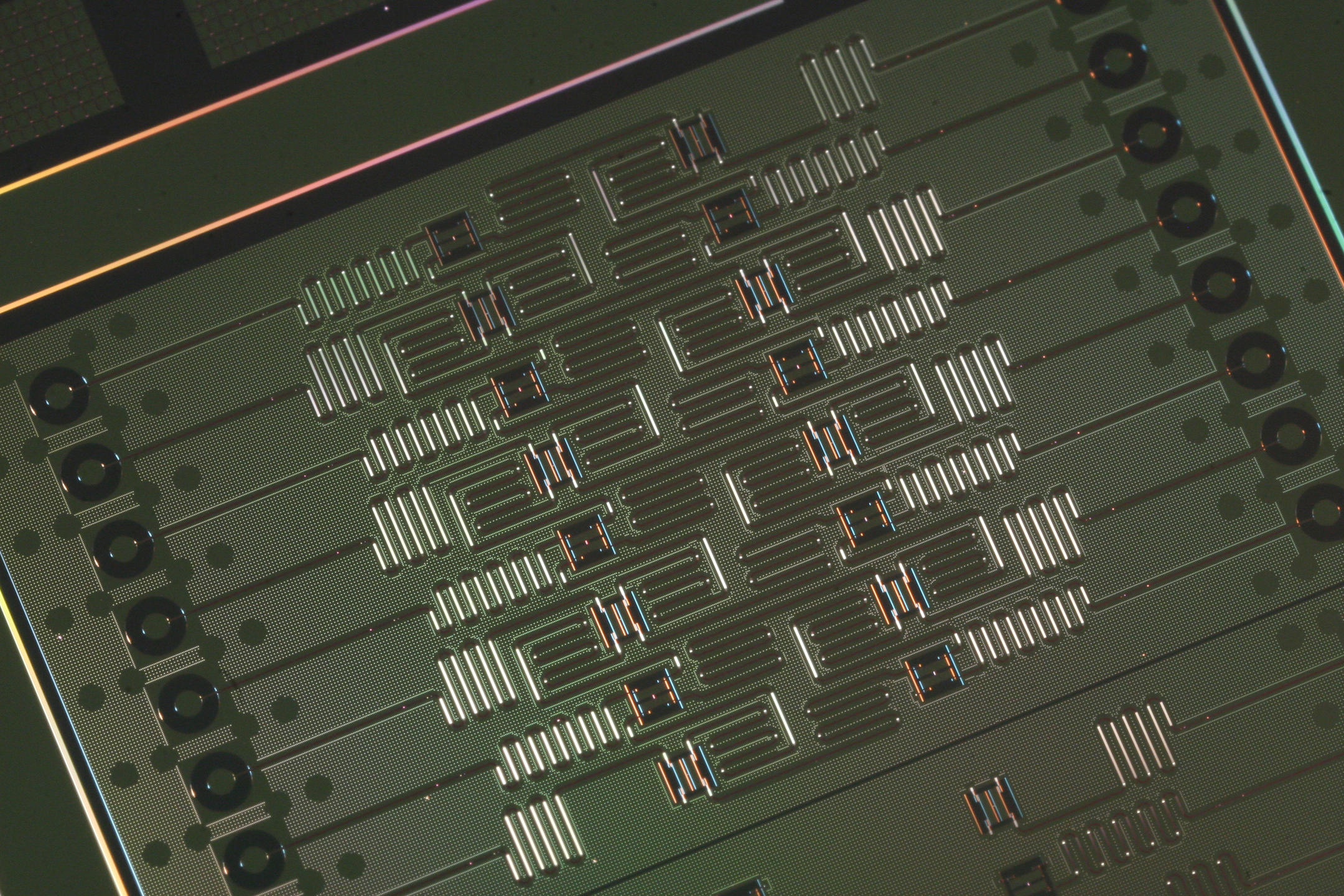

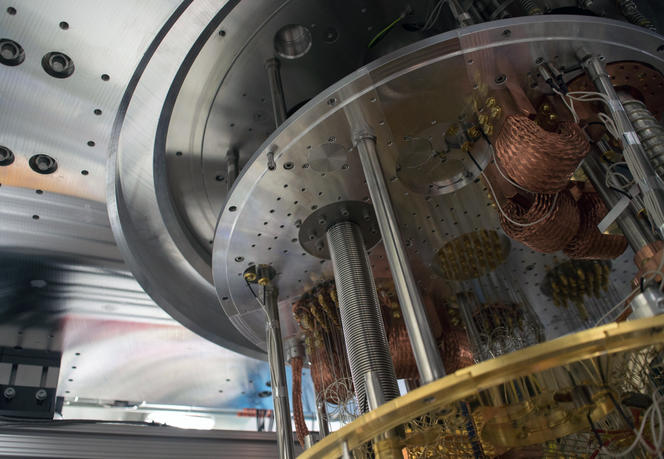

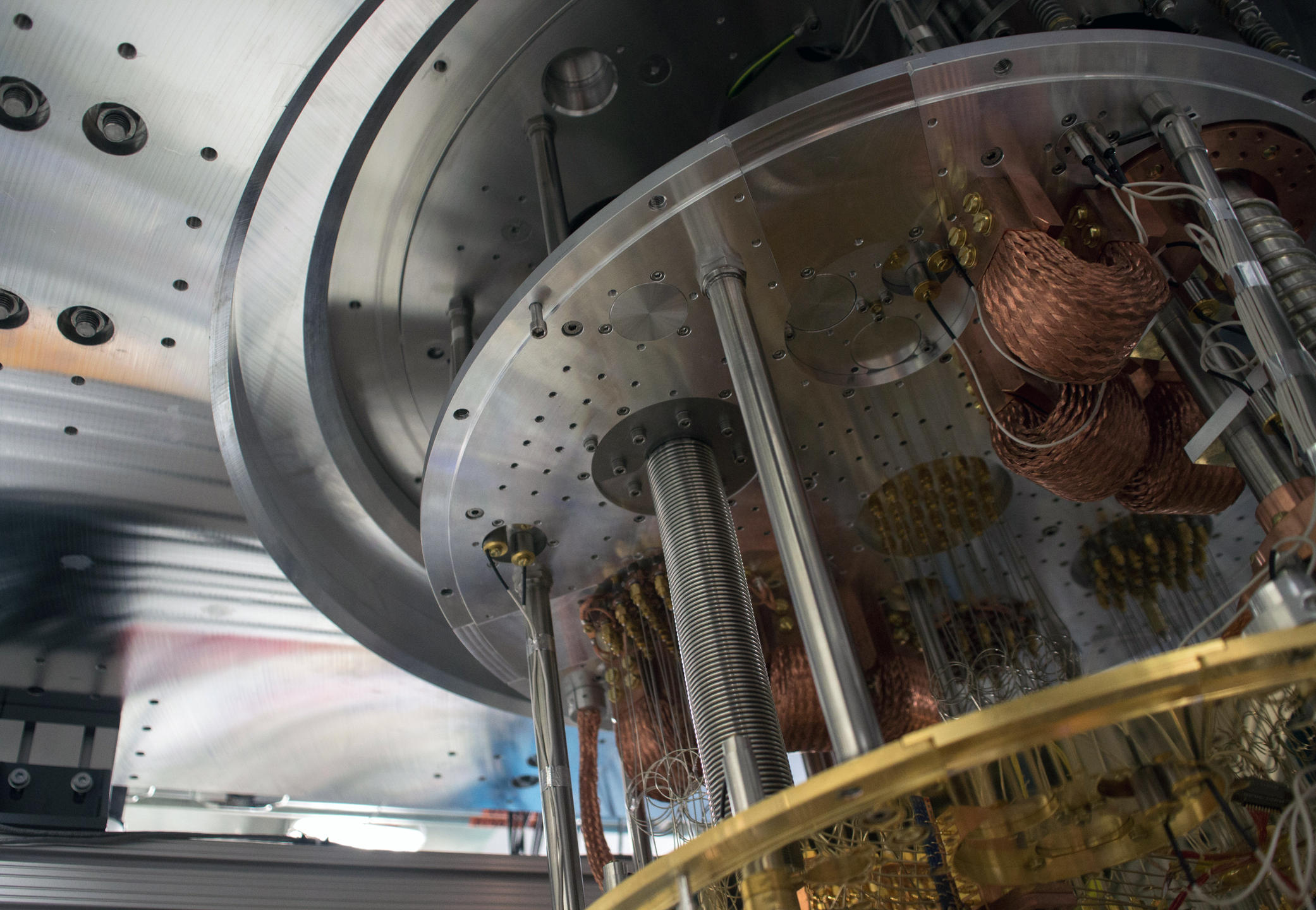

Second favori : les circuits supraconducteurs. Apparus à la fin des années 1990, ce sont des circuits électriques de taille micrométrique comportant des électrodes métalliques qui deviennent supraconductrices – c’est-à-dire qui conduisent l’électricité sans résistance – à très basse température. Grâce à des barrières isolantes ultra-fines entre ces électrodes, appelées jonctions Josephson, ces circuits se comportent comme des atomes artificiels dont il est possible de manipuler l’état quantique. En matière de décohérence, les qubits supraconducteurs font moins bien que les ions piégés mais ils sont en revanche plus rapides à manipuler.

Autre avantage selon Patrice Bertet, du Service de physique de l’état condensé au CEA Saclay5, laboratoire qui a eu un rôle pionnier dans le développement de ces systèmes : « Leur technique de fabrication est plutôt simple, ce qui permet de les dupliquer facilement et d’envisager d’en intégrer un grand nombre sur une même puce. » C’est ce qui explique pourquoi ces dispositifs sont aujourd’hui parmi les plus populaires auprès des industriels. Cette option a notamment été choisie par IBM et Google pour leurs machines.

Plus récemment, un troisième outsider est venu se joindre à la course : les spins d’électrons dans le silicium. Il s’agit là d’isoler des électrons dans une matrice de silicium et d’utiliser leur spin, sorte de rotation de la particule sur elle-même, comme bit quantique d’information. Développés depuis cinq ans seulement, ces qubits sont encore relativement « fragiles » et seuls deux d’entre eux ont pu être intriqués à ce jour. Mais de l’avis général, ils devraient parvenir bientôt aux mêmes niveaux de performance que les deux dispositifs pionniers. Et surtout, « ce sont les seuls qu’on pourra intégrer à très grande échelle.

En effet, leur fabrication, qui utilise exactement les mêmes techniques, déjà parfaitement maîtrisées, que celles de la micro et de la nanoélectronique, justement à base de silicium, fait qu’on peut les miniaturiser à l’extrême », avance Tristan Meunier. Enthousiaste sur le potentiel d’une telle technologie, le chercheur est un des responsables du projet nommé QuCube mené en partenariat avec deux autres laboratoires6 et dont l’objectif est la mise au point d’ici à six ans d’un processeur à base de silicium réunissant 100 qubits.

Alors, qui de ces trois candidats sortira en tête et conduira à la réalisation du premier ordinateur quantique ? « Impossible de le dire, chaque dispositif présentant certains avantages que ne possède pas l’autre. Aucun d’entre eux ne peut aujourd’hui prétendre à la victoire », estime Sébastien Tanzilli.

L’indispensable correction d’erreur

Une chose est sûre : améliorer les performances des qubits ne suffira pas. Pour faire de l’ordinateur quantique une réalité, il faudra aussi être capable de corriger les erreurs de calcul liées à la décohérence. Mathématiciens et informaticiens l’ont très vite compris et ont développé des codes correcteurs, l'équivalent quantique des algorithmes de correction d’erreur utilisés dans nos ordinateurs. Il a même été démontré que, en théorie, si le taux d’erreur d’un qubit est inférieur à une certaine valeur, alors il est possible de corriger les erreurs plus vite qu’elles ne se forment. « L'idée des codes correcteurs a été une petite révolution dans le domaine. Avec elle, même les plus pessimistes ont commencé à croire en la possibilité d’un ordinateur quantique », confie Sébastien Tanzilli.

Dans leur principe, les codes correcteurs sont simples. L’idée consiste à utiliser un groupe de plusieurs qubits dits « physiques » pour coder l’information d’un seul qubit dit « logique ». En mesurant les propriétés des qubits physiques, on sait alors – du fait de l'intrication – si le qubit logique n’est plus dans l’état souhaité et on le corrige immédiatement. En pratique, toutefois, leur mise en place est plus compliquée : on estime qu’il faudrait 1 000 – voire 10 000 – qubits physiques pour chaque qubit logique utilisable pour les calculs. Autrement dit, l’ordinateur quantique idéal devrait comporter non pas quelques milliers de qubits mais quelques millions ! « La manipulation et le contrôle d'un nombre aussi élevé de qubits reste largement hors de portée », avertit Patrice Bertet. Ce qui n’empêche pas les physiciens d’expérimenter ces méthodes sur un tout petit nombre de qubits.

De son côté, Eleni Diamanti reconnaît qu'il faudra une percée théorique pour rendre ces codes plus performants et donc moins gourmands en qubits. « C’est à ce prix-là seulement qu’on aura un ordinateur quantique digne de ce nom. Informaticiens, mathématiciens et physiciens y travaillent main dans la main, et je suis persuadée qu’ils arriveront un jour à bout de ce problème », avance-t-elle.

Vers des micro-calculateurs quantiques ?

Mais tout le monde ne souhaite pas attendre l’émergence de ces ordinateurs quantiques universels qui, dotés des meilleurs qubits et des codes correcteurs les plus performants, seraient capables de réaliser n’importe quel calcul complexe. « La tendance actuelle, qui suscite énormément de recherches, est d’identifier quels problèmes, avec quels algorithmes, pourraient être résolus par des machines intermédiaires, contenant moins de qubits et privées de système de correction des erreurs », note Iordanis Kerenidis de l’Institut de recherche en informatique fondamentale7 et directeur du Paris Centre for Quantum Computing.

La première étape vers cet objectif sera de démontrer la suprématie quantique, c’est-à-dire de prouver expérimentalement l’avantage du quantique sur le classique pour un algorithme donné. De l’avis des spécialistes, cette prouesse devrait être réalisée d’ici à cinq ans seulement, avec l’apparition de petits calculateurs quantiques dotés de 50 à 100 qubits. Les chercheurs s’y préparent et ont déjà identifié un type de problème mathématique – un calcul de distributions de probabilités – qui se prêtera à une telle démonstration. « Sa résolution n’aura certainement pas d’utilité pratique, mais elle lancera l’utilisation des machines quantiques pour des problèmes dignes d’intérêt », avance Iordanis Kerenidis.

Du calcul à la simulation quantique

Ce sont les domaines de la chimie et de la science des matériaux qui devraient en bénéficier les premiers. Avec des machines d’une centaine de qubits, prédit-on, la synthèse de nouvelles molécules ou la mise au point de matériaux aux propriétés inédites s’en trouvera largement accélérée. Comment ? En utilisant les ordinateurs quantiques non pas pour faire du calcul, mais de la simulation. L’idée, qui était d'ailleurs celle de Richard Feynman à l’origine, est d’imiter des systèmes physiques complexes (molécules, matériaux, etc.) à l’aide de systèmes quantiques artificiels plus simples : les qubits. En faisant varier à volonté les paramètres (distance des atomes, force des interactions...) qui ne sont pas ajustables dans les systèmes réels, on peut modéliser la dynamique de ces derniers et ainsi mieux les comprendre.

La simulation quantique a déjà abouti à des résultats mais avec l’augmentation du nombre de qubits, elle promet des avancées plus spectaculaires encore. « L’avantage de la simulation c’est que la décohérence n’est finalement plus une ennemie puisque les systèmes qu’on simule sont eux-mêmes soumis à ce phénomène. Nul besoin donc de disposer d’ordinateurs quantiques parfaits », souligne Simon Perdrix.

Avec des ordinateurs de plusieurs centaines de qubits, de nombreuses autres applications pourraient ensuite voir le jour.

Ce sont d’abord toutes les tâches d’optimisation qui pourraient être rendues beaucoup plus efficaces grâce au calcul quantique : de la gestion du trafic routier au maillage du transport de l’énergie en passant par la prédiction financière, de multiples secteurs devraient en bénéficier.

Une révolution pour l’apprentissage automatique ?

L’accélération de la vitesse de calcul promet aussi d’importantes retombées en matière d’apprentissage automatique, une technique très à la mode d’intelligence artificielle utilisée pour analyser et trier les informations dans de très grandes bases de données numériques. Là aussi, les applications seront multiples : amélioration des moteurs de recherche sur Internet, diagnostics médicaux beaucoup plus précis, pour ne citer qu’eux. « En optimisation comme en apprentissage automatique, on ne recherche pas des solutions exactes mais on cherche à apporter des réponses qui soient suffisamment satisfaisantes. On peut donc beaucoup mieux tolérer les erreurs que pour un problème de factorisation par exemple. C’est pourquoi l’utilisation d’ordinateurs quantiques même intermédiaires apportera énormément », insiste Iordanis Kerenidis.

Ce n’est donc pas un hasard si le champ de l’algorithmique quantique n’a jamais été aussi actif qu’aujourd’hui. Un seul exemple : en 2017, Iordanis Kerenidis a présenté un algorithme d’apprentissage automatique permettant, en théorie, de faire de la recommandation de films, de livres ou de rencontres de manière exponentiellement plus efficace qu’avec les méthodes actuelles. Bien malin qui pourra dire quand un véritable ordinateur quantique verra le jour et même s’il deviendra effectivement une réalité mais sur la route qui mènera à sa réalisation, les perspectives pour M. et Mme Tout-le-Monde promettent d'être extrêmement alléchantes. ♦

Partager cet article

Auteur

Julien Bourdet, né en 1980, est journaliste scientifique indépendant. Il a notamment travaillé pour Le Figaro et pour le magazine d’astronomie Ciel et Espace. Il collabore également régulièrement avec le magazine La Recherche.

Commentaires

Merci

Joel Filori le 15 Avril 2019 à 18h38Joël Filori

Joel Filori le 15 Avril 2019 à 18h39L'article explique bien mieux

Jacques Bolo le 10 Mai 2019 à 18h28Je me pose une question qui

Vince2505 le 28 Août 2019 à 11h55C'est absolument fascinant,

JL de Sauverzac le 30 Janvier 2021 à 09h20Connectez-vous, rejoignez la communauté

du journal CNRS