Vous êtes ici

Le robot, un «animal» comme les autres ?

Nos interactions sociales, culturelles, économiques et politiques font une place grandissante à un nouveau type d’acteurs : les machines dotées d'une intelligence artificielle. Ces machines filtrent les informations qui nous parviennent, nous guident dans la recherche d’un conjoint, et conversent avec nos enfants. Elles échangent des titres sur les marchés financiers, elles conseillent les juges et les policiers. Bientôt, elles conduiront nos voitures et feront la guerre à notre place. Si nous voulons garder ces machines sous contrôle, en tirer les plus grands bénéfices et en minimiser les dommages potentiels, il nous faut comprendre leur comportement.

Comprendre le comportement des machines intelligentes est un objectif plus large que de comprendre leur programmation. Parfois, la programmation d’une machine n’est pas accessible, par exemple quand son code est un secret industriel. Dans ce cas, il est nécessaire de comprendre une machine de l’extérieur, en observant ses actions et en mesurant leurs conséquences. D’autres fois, il n’est pas possible de prédire complètement le comportement d’une machine à partir de son code, parce que ce comportement va changer de façon complexe quand la machine s’adaptera à son environnement, par un processus d’apprentissage certes guidé mais ultimement opaque. Dans ce cas, il est nécessaire d’observer en continu ce comportement et d’en simuler les évolutions potentielles. Enfin, même quand l’on peut prédire le comportement d’une machine à partir de son code, il est difficile de prédire comment les actions de la machine vont changer le comportement des humains (qui ne sont pas, eux, programmables), et comment les actions des humains vont en retour changer le comportement de la machine. Dans ce cas, il est nécessaire de mener des expériences pour anticiper la coévolution culturelle des humains et des machines.

Une nouvelle science pour observer les machines

Afin de relever tous ces défis, nous devons créer une nouvelle discipline scientifique, dédiée au comportement des machines, comme nous avons créé la discipline scientifique du comportement animal. On ne peut comprendre le comportement des animaux uniquement sur la base de la génétique, de la chimie organique ou de l’anatomie cérébrale : on a également besoin de méthodes observationnelles et expérimentales, étudiant l’animal dans son environnement ou en laboratoire.

De la même façon, on ne peut comprendre le comportement des machines intelligentes uniquement sur la base de l’informatique ou de la robotique : on a également besoin de spécialistes du comportement entraînés aux méthodes expérimentales dans les champs de la psychologie, de l'économie, des sciences politiques ou de l'anthropologie.

Une discipline scientifique n’est jamais créée de toutes pièces. Le comportement des animaux était étudié par de très nombreux scientifiques bien avant que l’étude du comportement animal ne soit formalisée en tant que discipline structurée et indépendante. De la même façon, de nombreux scientifiques se reconnaîtront dans la discipline du comportement des machines, une fois que cette discipline sera structurée et identifiée. Mais le plus important est qu’ils et elles se reconnaîtront entre eux, bien plus facilement qu’aujourd’hui.

En rassemblant ce qui est aujourd’hui épars, nous permettrons aux chercheurs en comportement des machines de s’identifier mutuellement et d’organiser leur coopération au travers des frontières disciplinaires actuelles ; nous permettrons aux pouvoirs publics et aux agences de régulation de s’appuyer plus facilement sur un corpus scientifique aujourd’hui dispersé et difficile d’accès ; et nous permettrons aux citoyens de s’orienter plus lucidement dans un monde bouleversé par l’émergence des machines intelligentes.

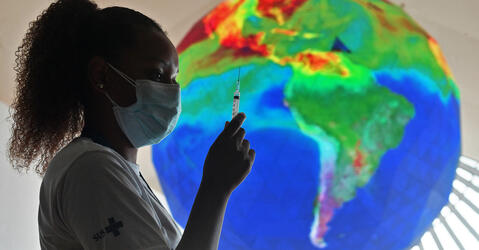

C’est là la motivation d’un appel aux chercheurs, aux décideurs publics, et aux entreprises qui façonnent les machines intelligentes, que j’ai récemment publié dans la revue Nature avec 22 coauteurs européens et américains, informaticiens, sociologues, biologistes, économistes, ingénieurs, politistes, anthropologues et psychologues, chercheurs dans des organismes de recherche publique, universitaires, ou employés par les géants de l’intelligence artificielle que sont Microsoft, Facebook ou Google. Nous y examinons les grandes questions susceptibles de fonder le champ du comportement des machines, inspirées par les questions qui ont fondé le champ du comportement animal.

Comment un comportement est-il façonné puis évolue-t-il ?

Parmi ces grandes questions figure celle des incitations sociales et économiques qui ont façonné le comportement initialement attendu d’une machine. Par exemple, quelle est la métrique que tentait initialement de maximiser un algorithme de filtrage d’information sur les réseaux sociaux et quels sont les effets psychosociaux inattendus de cet objectif initial ?

Autre type de grandes questions : par quels mécanismes un comportement a-t-il été acquis et par quels mécanismes a-t-il été modifié ? Par exemple, sur quel type de données un algorithme de police prédictive a-t-il été initialement entraîné ? Si ces données étaient biaisées contre un groupe social particulier, l’algorithme est-il susceptible d’amplifier ce biais par ses décisions et ainsi d’entrer dans une spirale d’injustice ?

Savoir dans quel environnement un comportement peut se maintenir ou se propager, et dans quel environnement il est voué à disparaître, fait aussi partie des grandes questions que nous avons examinées. Par exemple, une archive ouverte d’algorithmes pour voitures autonomes peut-elle permettre à la programmation d’un modèle de voiture de se propager rapidement à tous les autres modèles, avant même qu’un quelconque problème puisse être détecté par le régulateur ?

Toutes ces interrogations doivent être déclinées à l’échelle d’une machine isolée, d’une machine interagissant avec d’autres machines, et à l’échelle des collectifs hybrides formés par les humains et les machines. Toutes sont essentielles, mais elles sont aujourd’hui étudiées en ordre dispersé par des communautés qui peinent à se reconnaître. Rassembler ces communautés sous la bannière de la nouvelle science du comportement des machines sera une étape décisive pour prendre harmonieusement le tournant de l’intelligence artificielle. ♦

Les points de vue, les opinions et les analyses publiés dans cette rubrique n’engagent que leur auteur. Ils ne sauraient constituer une quelconque position du CNRS.

Partager cet article

Commentaires

Connectez-vous, rejoignez la communauté

du journal CNRS

L'#IA est déjà un modèle du

Jacques Bolo le 10 Mai 2019 à 15h06