Vous êtes ici

Modéliser plus pour simuler moins

Frédéric Alexandre, vous êtes chercheur au Laboratoire bordelais de recherche en informatique (LaBRI1) et intervenant du colloque « Modélisation : succès et limites » qui se tient le 6 décembre 2016. Qu’entend-on au juste aujourd'hui par modélisation et simulation ?

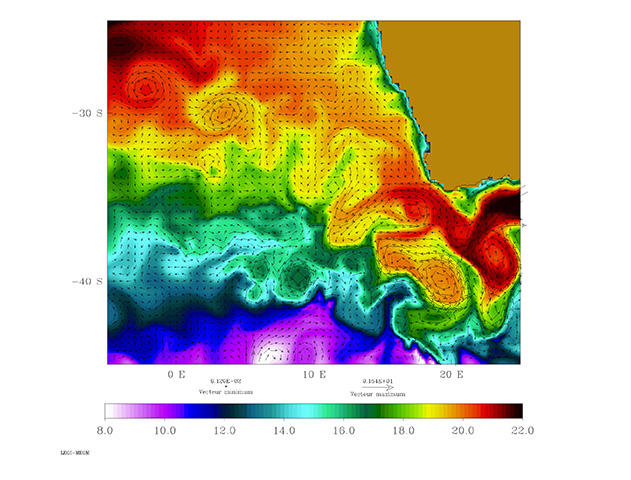

F. A. : La dimension numérique s'est intensément développée dans tous les domaines où l'on sait représenter les phénomènes par des équations que l'on peut ensuite implanter informatiquement – on parle alors de modèles de connaissance. Ce phénomène s’est amplifié, surtout dernièrement avec la possibilité d'utiliser les données massives (big data) et l’apprentissage automatique (machine learning) pour faire des statistiques – on parle dans ce cas de modèles de représentation.

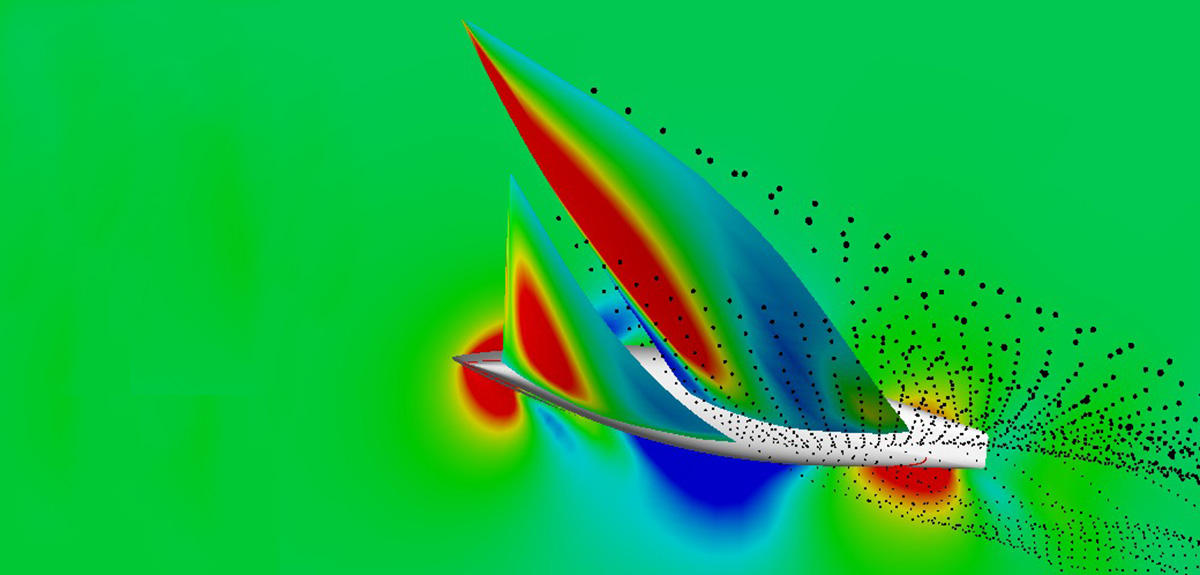

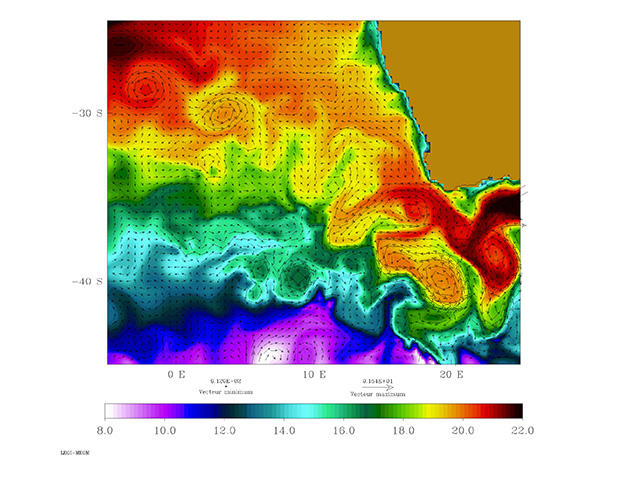

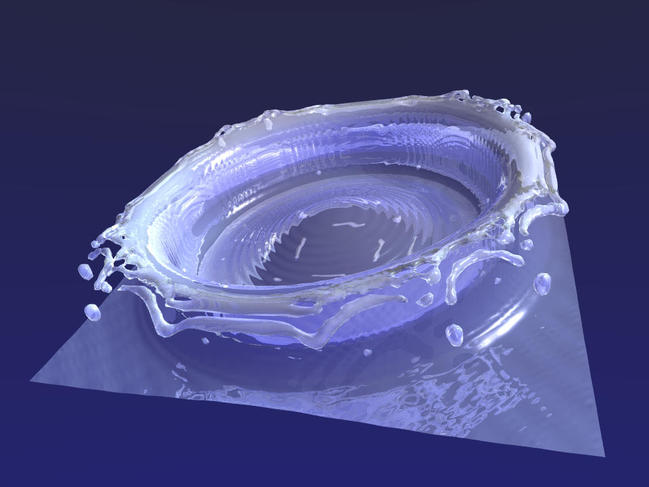

Mais construire une maquette et la mettre dans une soufflerie, c’est aussi modéliser et simuler. Construire un modèle est un processus particulier : il s'agit de choisir un cadre théorique, un formalisme pour décrire un objet d’étude, et que l'ensemble soit adapté à la question que l’on se pose sur cet objet. C’est aussi prévoir, dès sa conception, le moyen de valider ce modèle : il faut pouvoir montrer qu’il répond bien à la question posée. Le simuler, c’est le mettre en œuvre informatiquement, via des logiciels en adoptant notamment des schémas de calcul, et des matériels en utilisant une architecture adaptée aux calculs à réaliser, pouvant associer des processeurs spécifiques comme des processeurs graphiques, des grappes de machines homogènes (clusters) ou un ensemble de ressources hétérogènes et éventuellement délocalisées, la grille. Il faut également noter que gérer ces matériels nécessite de recourir à des logiciels dits intermédiaires (middleware). Le principe de cette simulation consiste à pouvoir, à ce stade, faire varier des paramètres pour voir comment le modèle évolue.

Quels sont les liens que ces concepts entretiennent avec ceux de théorie, de découverte et de preuve ?

F. A. : À la différence des données qui sont de simples observations d’un objet d’étude, une théorie vise à fournir des explications sur cet objet. Quand une théorie ne peut être prouvée par simple déduction logique – le cas le plus fréquent –, le recours à un modèle permet de mettre en œuvre cette théorie et, éventuellement, de la réfuter expérimentalement par des simulations. Une réfutation impose de modifier le modèle, voire de proposer une nouvelle théorie et de la corroborer par de nouveaux tests. Notons que le modèle et la théorie qu’il sous-tend sont ajustés par une série de mises au point expérimentales, sans que l’on puisse toutefois jamais parler de vérité définitive. En effet, comme le postule l’épistémologue Karl Popper, une théorie scientifique doit fournir une explication aux phénomènes observés – la meilleure disponible à un moment donné –, mais elle doit aussi fournir les conditions de sa propre réfutation.

En quoi cette démarche de modélisation-simulation a-t-elle bouleversé la façon de faire de la recherche dans certaines disciplines ?

F. A. : La croissance des puissances de calcul disponibles et la mise à disposition de logiciels d’aide à la mise en œuvre des simulations a effectivement rendu l’accès à cette boucle modélisation-simulation très facile. On pourrait presque dire trop facile… Par exemple, en 2014, dans le film Interstellar, il a été jugé plus simple de recourir à des simulations physiques pour représenter des vagues géantes. Le risque est alors de produire des simulations rapidement et facilement sans se poser trop de questions sur le domaine de validité des modèles associés ; ce qui, dès la sortie d’Interstellar, a conduit à des débats interminables entre physiciens quant au choix précis des conditions initiales utilisées pour la simulation.

On a tendance à penser que réaliser des simulations de plus en plus performantes requiert des puissances de calcul de plus en plus grandes ; mais est-ce vraiment le cas ? Et peut-on augmenter indéfiniment cette puissance ?

F. A. : Ce n’est pas forcément le cas, car les progrès sont aussi dus aux améliorations des logiciels de mise en œuvre qui réalisent effectivement des prouesses pour utiliser au mieux les architectures de calcul. Ces quinze dernières années, les progrès réalisés sur les algorithmes de calcul d'algèbre linéaire ont autant contribué à l'accélération des calculs que l’augmentation de la puissance des processeurs.

les progrès des algorithmes ont autant contribué à l'accélération des calculs que la puissance des processeurs.

On nous annonce depuis longtemps la fin de la loi de Moore relative à l'accroissement régulier de la puissance des ordinateurs. Le débat pourrait effectivement porter sur le fait que cette étape commence effectivement à se faire sentir ou que le génie humain trouvera toujours des solutions de substitution. Mais je pense qu'il est plus important de savoir si l’on a intérêt à développer des modèles de plus en plus complexes lorsque cela se fait au détriment d'une réflexion sur la nature et la pertinence des modèles utilisés. Et puis, faire tourner des clusters de machines a aussi un coût économique et écologique !

Ensuite, et de façon peut-être plus profonde, faire tourner rapidement un modèle en dehors de ses limites de validité ne le rend pas plus valide !

Un modèle plus simple mais plus adapté est toujours préférable. Autant on peut justifier l'accroissement du recours aux simulations quand il s'agit de faire tourner un modèle plus longtemps, sur une plus grande extension spatiale, ou de tester plus de jeux de paramètres, autant il convient de rester prudent quand on change d’échelle ou quand, par exemple, on agrège plusieurs modèles.

Vaudrait-il mieux complexifier ou plutôt simplifier ces modèles et simulations pour s'approcher au mieux de la réalité ?

F. A. : Pour répondre à cette question difficile, il faut d’abord introduire un autre acteur. En plus des modèles théoriques associés aux simulations numériques, il y a maintenant le duo big data-machine learning : là, des corpus gigantesques sont analysés par des procédures d’apprentissage automatique s’appuyant sur des modèles statistiques. Par exemple, dans le domaine du traitement automatique du langage, plutôt que de travailler sur la mise au point de modèles de langage, il est aujourd’hui plus efficace d’analyser statistiquement des corpus de millions de phrases pour faire des systèmes de traduction automatique performants. Et l'on peut penser qu’il en sera bientôt de même pour la description d’objets physiques où le recours aux équations de la physique sous-jacente serait moins efficace que l’analyse d’un corpus d’exemples…

Sans remettre en cause les performances bien réelles et même impressionnantes de ces systèmes, on peut simplement remarquer qu’ils poussent au bout la logique de la puissance de calcul au détriment de l’analyse de l’objet d’étude. Analyse qui aurait pu parfois permettre de trouver une solution plus élégante et surtout plus porteuse de sens. De gros modèles très paramétrés peuvent coller à beaucoup de données sans en extraire la logique sous-jacente. Prédire n’est pas expliquer, rappelle René Thom.

Et surtout – pour répondre enfin à la question –, ces deux approches, tant statistiques que théoriques, couplées à une utilisation massive de la simulation oublient parfois le principal : quelle est la question posée et le modèle est-il bien conçu pour y répondre ? Ces approches massives sont bien adaptées et commencent aujourd’hui à être bien maîtrisées sur des questions relatives à des phénomènes relativement réguliers. Toutefois, dès lors que ces phénomènes impliquent des considérations humaines, sociales, politiques ou cognitives, bien formuler les questions que l’on se pose et définir un modèle plus simple est souvent plus pertinent qu’appuyer tout de suite sur le bouton rouge de la simulation.

Pour en savoir plus sur le colloque : Modélisation : succès et limites

- 1. Unité CNRS/Univ. Bordeaux/Bordeaux INP

Mots-clés

Partager cet article

Auteur

Lydia Ben Ytzhak est journaliste scientifique indépendante. Elle travaille notamment pour la radio France Culture, pour laquelle elle réalise des documentaires, des chroniques scientifiques ainsi que des séries d’entretiens.

Commentaires

Connectez-vous, rejoignez la communauté

du journal CNRS